Quatro casos de deepfakes sexuais envolvendo estudantes foram registrados em escolas de São Paulo, segundo levantamento da SaferNet, organização que promove a defesa dos Direitos Humanos na internet no Brasil.

No país, o estudo identificou ocorrências desse tipo em 10 estados, incluindo Minas Gerais, Rio de Janeiro e Paraná.

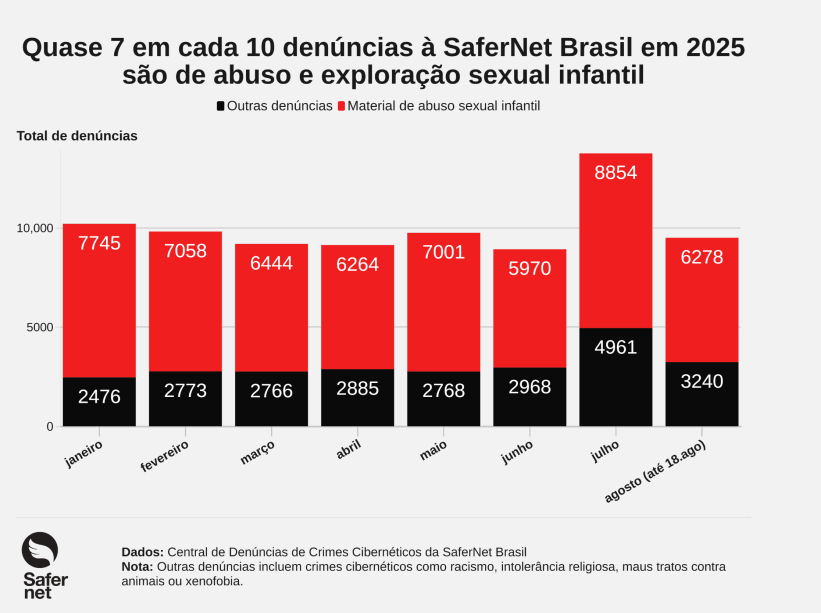

Entre 1º de janeiro e 31 de julho de 2025, a SaferNet recebeu 76.997 denúncias de crimes digitais, sendo 49.336 (64%) relacionadas a abuso e exploração sexual infantil — quase sete em cada dez notificações.

O aumento coincidiu com a repercussão do vídeo “Adultização”, publicado em 6 de agosto pelo influenciador Felca, que atingiu 46 milhões de visualizações e estimulou 6.278 novas denúncias, metade delas após o vídeo.

O levantamento também aponta um avanço preocupante no uso da IA generativa para criar e disseminar material sexual envolvendo crianças e adolescentes. Aplicativos permitem gerar imagens hiper-realistas, incluindo fotos manipuladas e animações (deepfakes) com vozes e rostos de menores.

Esses conteúdos circulam rapidamente em redes sociais, aplicativos de mensagens e sites de pornografia com pouca moderação, expondo vítimas a assédio, bullying e traumas contínuos.

A facilidade de disseminação aumenta o risco, e muitos casos ocorrem em ambiente escolar, entre adolescentes.

Outro padrão identificado pela ONG é que sites de pornografia e conteúdo adulto, por falhas ou ausência de mecanismos de moderação eficazes, acabam armazenando materiais de abuso e exploração sexual de crianças e adolescentes criados por IA.

A SaferNet já havia sinalizado o problema no Brasil há algum tempo. Em 2024, um grupo com 46 mil membros vendia deepfakes de celebridades brasileiras por valores entre R$ 19,90 e R$ 25, mostrando a escala industrial do problema.

Foram identificadas 95 denúncias com a palavra-chave “inteligência artificial”, incluindo 12 referentes a um único site que hospedava material de abuso infantil entre 2024 e 2025. A organização alerta que esses números representam apenas a ponta do iceberg, com múltiplas vítimas ainda fora do radar das autoridades.

O levantamento recomenda medidas preventivas, como orientação digital para estudantes, campanhas educativas e políticas internas nas escolas para coibir o compartilhamento de imagens manipuladas.

Para Juliana Cunha, diretora da SaferNet responsável pela pesquisa, trata-se de um fenômeno recente e em rápida evolução.

“O resultado desta pesquisa é a proposição de recomendações acionáveis para diferentes atores: empresas de tecnologia, que devem prevenir e mitigar riscos; o poder público, responsável por regular e fiscalizar; e a sociedade civil, que precisa atuar na conscientização e na denúncia”, explicou.

Estudo: IA aumenta a criação de deepfakes de pornografia com mulheres

A criação e divulgação desses conteúdos configura crime previsto no Código Penal (art. 6°, II), com possibilidade de responsabilização civil e criminal. Até o momento, as autoridades de segurança pública não divulgaram dados oficiais sobre prisões ou processos relacionados aos casos.

* Sob supervisão de Tonny Aranha